Mjeti, i quajtur Nightshade, prish të dhënat e trajnimit në mënyra që mund të shkaktojnë dëme serioze në modelet e AI që gjenerojnë imazhe.

Një mjet i ri i lejon artistët të shtojnë ndryshime të padukshme në pikselët në artin e tyre përpara se ta ngarkojnë atë në internet, në mënyrë që nëse gërvishtet në një grup trajnimi AI, mund të shkaktojë që modeli që rezulton të thyhet në mënyra kaotike dhe të paparashikueshme.

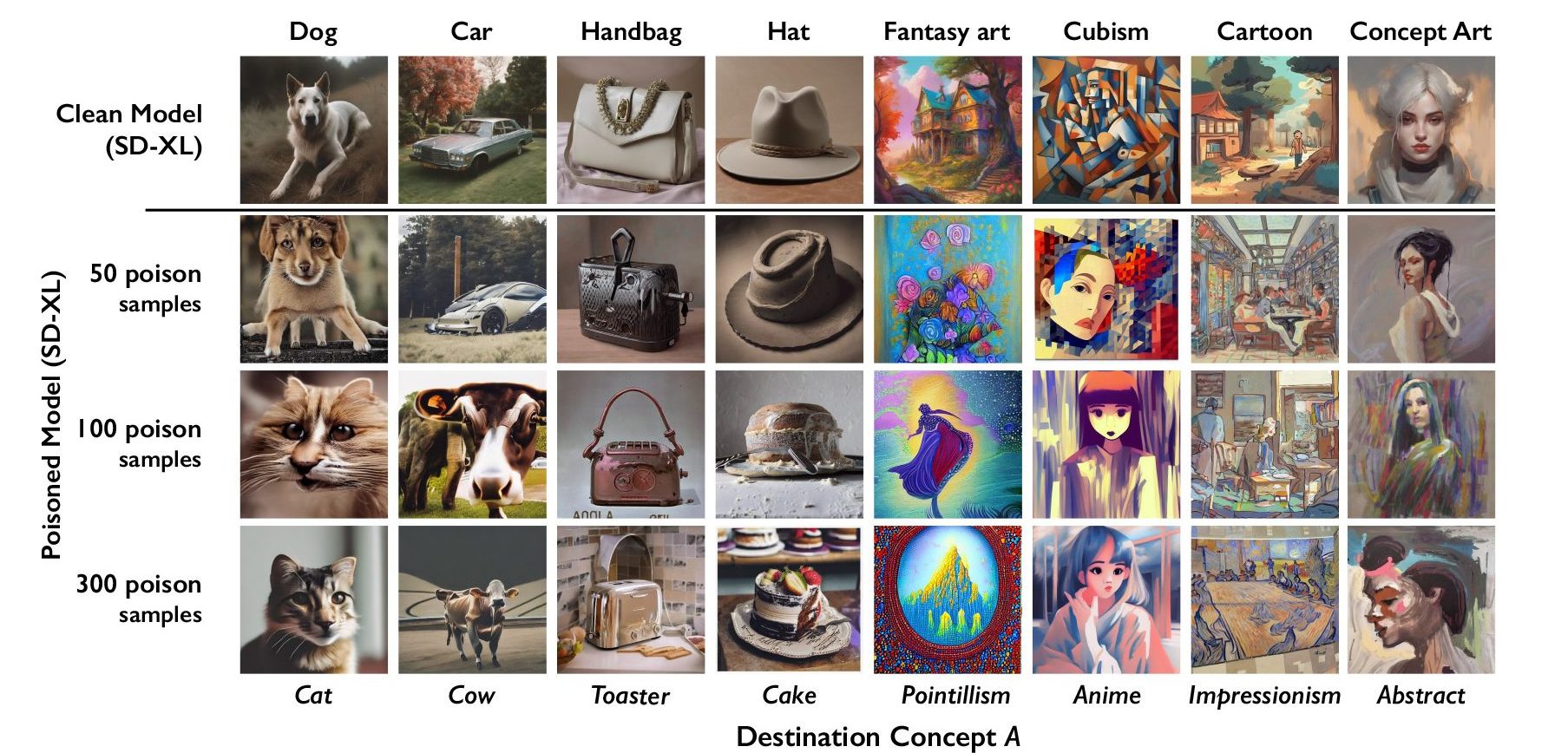

Mjeti, i quajtur Nightshade, synohet si një mënyrë për të luftuar kompanitë e AI që përdorin punën e artistëve për të trajnuar modelet e tyre pa lejen e krijuesit. Përdorimi i tij për të “helmuar” këto të dhëna trajnimi mund të dëmtojë përsëritjet e ardhshme të modeleve të AI që gjenerojnë imazhe, të tilla si DALL-E, Midjourney dhe Stable Diffusion, duke i bërë disa nga rezultatet e tyre të padobishme – qentë bëhen mace, makinat bëhen lopë, etj. me radhë. MIT Technology Review mori një vrojtim ekskluziv të hulumtimit, i cili është dorëzuar për shqyrtim nga kolegët në konferencën e sigurisë kompjuterike Usenix.

Kompanitë e inteligjencës artificiale si OpenAI, Meta, Google dhe Stability AI po përballen me një mori padish nga artistë që pretendojnë se materiali i tyre me të drejtë autori dhe informacioni personal u fshinë pa pëlqim ose kompensim. Ben Zhao, një profesor në Universitetin e Çikagos, i cili udhëhoqi ekipin që krijoi Nightshade, thotë se shpresa është se do të ndihmojë në kthimin e balancës së fuqisë nga kompanitë e AI drejt artistëve, duke krijuar një pengesë të fuqishme kundër mosrespektimit të të drejtave të autorit dhe intelektualëve të artistëve. prone. Meta, Google, Stability AI dhe OpenAI nuk iu përgjigjën kërkesës së MIT Technology Review për koment se si mund të përgjigjen.

Mos u mjaftoni me gjysmën e historisë.

Merrni akses pa pagesë në lajmet e teknologjisë këtu dhe tani.

Abonohu tani

Tashmë një abonent? Hyni

Ekipi i Zhaos zhvilloi gjithashtu Glaze, një mjet që lejon artistët të “maskojnë” stilin e tyre personal për të parandaluar që ai të gërvishtet nga kompanitë e AI. Ai funksionon në një mënyrë të ngjashme me Nightshade: duke ndryshuar pikselat e imazheve në mënyra delikate që janë të padukshme për syrin e njeriut, por manipulojnë modelet e mësimit të makinës për të interpretuar imazhin si diçka ndryshe nga ajo që tregon në të vërtetë.

Ekipi synon të integrojë Nightshade në Glaze dhe artistët mund të zgjedhin nëse duan të përdorin mjetin për helmimin e të dhënave apo jo. Ekipi po bën gjithashtu Nightshade me burim të hapur, i cili do t’i lejojë të tjerët të ndërhyjnë me të dhe të bëjnë versionet e tyre. Sa më shumë njerëz ta përdorin atë dhe të bëjnë versionet e tyre, aq më i fuqishëm bëhet mjeti, thotë Zhao. Kompletet e të dhënave për modelet e mëdha të AI mund të përbëhen nga miliarda imazhe, kështu që sa më shumë imazhe të helmuara të mund të gërvishten në model, aq më shumë dëme do të shkaktojë teknika.

Një sulm i synuar

Nightshade shfrytëzon një dobësi sigurie në modelet gjeneruese të AI, që lind nga fakti se ata janë të trajnuar për sasi të mëdha të dhënash – në këtë rast, imazhe që janë hequr nga interneti. Nightshade ngatërrohet me ato imazhe.

Artistët që duan të ngarkojnë punën e tyre në internet, por nuk duan që imazhet e tyre të gërvishten nga kompanitë e AI, mund t’i ngarkojnë ato në Glaze dhe të zgjedhin ta maskojnë atë me një stil arti të ndryshëm nga i tyri. Ata pastaj mund të zgjedhin gjithashtu të përdorin Nightshade. Sapo zhvilluesit e AI gërvishtin internetin për të marrë më shumë të dhëna për të rregulluar një model ekzistues të AI ose për të ndërtuar një të ri, këto mostra të helmuara hyjnë në grupin e të dhënave të modelit dhe shkaktojnë keqfunksionim të tij.

Mostrat e të dhënave të helmuara mund të manipulojnë modelet për të mësuar, për shembull, se imazhet e kapelave janë ëmbëlsira, dhe imazhet e çantave të dorës janë tostera. Të dhënat e helmuara janë shumë të vështira për t’u hequr, pasi kërkon që kompanitë e teknologjisë të gjejnë dhe fshijnë me kujdes çdo mostër të korruptuar.

Studiuesit testuan sulmin në modelet më të fundit të Stable Diffusion dhe në një model AI ata u trajnuan nga e para. Kur ata ushqyen Stable Diffusion me vetëm 50 imazhe të helmuara të qenve dhe më pas e shtynë atë të krijonte imazhe të vetë qenve, rezultati filloi të dukej i çuditshëm – krijesa me shumë gjymtyrë dhe fytyra vizatimore. Me 300 mostra të helmuara, një sulmues mund të manipulojë Stable Diffusion për të gjeneruar imazhe të qenve që të duken si mace.

KURTEZIA E HULUMTUESVE

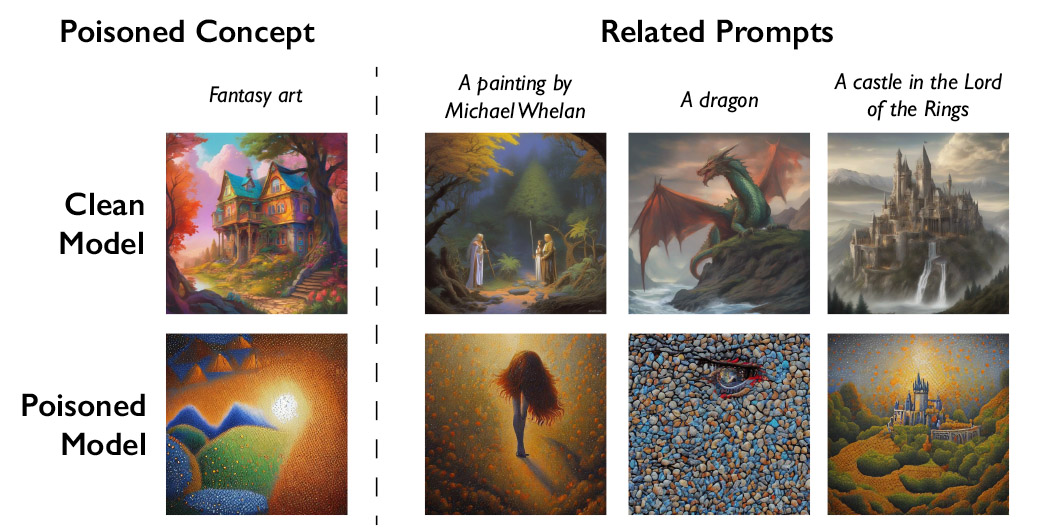

Modelet gjeneruese të AI janë të shkëlqyera në krijimin e lidhjeve midis fjalëve, gjë që ndihmon në përhapjen e helmit. Nightshade infekton jo vetëm fjalën “qen”, por të gjitha konceptet e ngjashme, të tilla si “qenush”, “husky” dhe “ujk”. Sulmi helmues funksionon gjithashtu në imazhe të lidhura në mënyrë tangjenciale. Për shembull, nëse modelja gërvishti një imazh të helmuar për “artin e fantazisë”, nxit “dragon” dhe “një kështjellë në Zoti i unazave” do të manipulohej në mënyrë të ngjashme në diçka tjetër.

KURTEZIA E HULUMTUESVE

Zhao pranon se ekziston rreziku që njerëzit të abuzojnë me teknikën e helmimit të të dhënave për përdorime me qëllim të keq. Megjithatë, ai thotë se sulmuesit do të kishin nevojë për mijëra mostra të helmuara për të shkaktuar dëme reale në modele më të mëdha dhe më të fuqishme, pasi ata janë trajnuar në miliarda mostra të dhënash.

“Ne nuk dimë ende për mbrojtje të fuqishme kundër këtyre sulmeve. Ne nuk kemi parë ende sulme helmuese ndaj modeleve moderne (të mësuarit me makinë) në natyrë, por mund të jetë vetëm çështje kohe,” thotë Vitaly Shmatikov, një profesor në Universitetin Cornell që studion sigurinë e modelit të AI dhe nuk ishte i përfshirë në kërkimore. “Koha për të punuar në mbrojtje është tani”, shton Shmatikov.

Gautam Kamath, një asistent profesor në Universitetin e Waterloo-s, i cili hulumton privatësinë dhe qëndrueshmërinë e të dhënave në modelet e AI dhe nuk ishte i përfshirë në studim, thotë se puna është “fantastike”.

Hulumtimi tregon se dobësitë “nuk zhduken në mënyrë magjike për këto modele të reja, dhe në fakt bëhen më serioze”, thotë Kamath. “Kjo është veçanërisht e vërtetë pasi këto modele bëhen më të fuqishme dhe njerëzit kanë më shumë besim tek ata, pasi aksionet rriten vetëm me kalimin e kohës.”

Një parandalues i fuqishëm

Junfeng Yang, një profesor i shkencave kompjuterike në Universitetin e Kolumbisë, i cili ka studiuar sigurinë e sistemeve të të mësuarit të thellë dhe nuk ishte i përfshirë në punë, thotë se Nightshade mund të ketë një ndikim të madh nëse i bën kompanitë e AI të respektojnë më shumë të drejtat e artistëve – për shembull. , duke qenë më i gatshëm për të paguar honoraret.

Kompanitë e inteligjencës artificiale që kanë zhvilluar modele gjeneruese tekst-në-imazh, si Stability AI dhe OpenAI, kanë ofruar t’i lejojnë artistët të heqin dorë nga përdorimi i imazheve të tyre për të trajnuar versionet e ardhshme të modeleve. Por artistët thonë se kjo nuk mjafton. Eva Toorenent, një ilustrues dhe artiste që ka përdorur Glaze, thotë se politikat e heqjes dorë nga artistët kërkojnë që artistët të kërcejnë dhe t’i lënë kompanitë e teknologjisë me gjithë fuqinë.

Toorenent shpreson se Nightshade do të ndryshojë status quo-në.

“Kjo do t’i bëjë (kompanitë e AI) të mendojnë dy herë, sepse ata kanë mundësinë të shkatërrojnë të gjithë modelin e tyre duke marrë punën tonë pa pëlqimin tonë,” thotë ajo.

Autumn Beverly, një tjetër artiste, thotë se mjete si Nightshade dhe Glaze i kanë dhënë asaj besimin për të postuar sërish punën e saj në internet. Ajo më parë e hoqi atë nga interneti pasi zbuloi se ishte gërvishtur pa pëlqimin e saj në bazën e të dhënave popullore të imazheve LAION.

“Jam vërtet mirënjohëse që kemi një mjet që mund të ndihmojë në kthimin e fuqisë tek artistët për punën e tyre,” thotë ajo.